Hướng dẫn sử dụng Robots.txt để tối ưu chuẩn SEO cho Blogger

Trong bài viết này mình sẽ hướng dẫn các bạn cách sử dụng Robots.txt tùy chỉnh trên Blogspot đúng chuẩn nhất, đây là phương pháp giúp cho bài viết trên blog của bạn sẽ có thứ hạng cao hơn trong công cụ tìm kiếm.

Robots.txt là một file văn bản trên máy chủ, có vai trò giúp người dùng blog có thể tạo ra các thư mục, trang web hoặc liên kết nhưng sẽ không xuất hiện trong kết quả tìm kiếm. Điều đó có nghĩa là bạn có thể hạn chế việc các công cụ tìm kiếm thu thập dữ liệu vào một số thư mục và trang web hoặc đường link trên trang blog của mình.

|

| Cách sử dụng Robots.txt để tối ưu SEO cho blogspot |

Hiện tại, người dùng đã có thể tùy chỉnh robot.txt trên trang Blogger của mình. Trong tùy chọn tìm kiếm Blogger thường sẽ liên quan đến nhãn và tiêu đề của bài viết, do đó nếu người dùng không sử dụng nhãn và tiêu đề đúng cách trên mỗi bài đăng, thì việc thu thập thông tin của liên kết tìm kiếm sẽ không hoạt động hiệu quả. Theo mặc định của trang Blogger, thì liên kết tìm kiếm sẽ không được phép thu thập dữ liệu của người dùng. Còn trong file robots.txt này, bạn cũng có thể tạo vị trí của file sơ đồ trang web của mình. Sơ đồ trang web là một file nằm trên máy chủ chứa tất cả các permalinks của trang web hoặc blog, chủ yếu là sơ đồ trang web với định dạng XML, tức là sitemap.xml.

2. Các loại Robots.txt

Ở thời điểm hiện tại, Blogger đang hoạt động trên sitemap.xml và sẽ thu thập các mục sơ đồ trang web thông qua nguồn cấp dữ liệu. Theo phương pháp này, 25 bài đăng gần đây nhất trên trang blog của bạn sẽ được gửi đến các công cụ tìm kiếm. Nếu bạn muốn các công cụ tìm kiếm chỉ hoạt động trên 25 bài đăng gần đây nhất thì bạn nên sử dụng robot.txt loại 1 sẽ được mình giới thiệu dưới đây. Nếu bạn sử dụng robot.txt loại này, thì công cụ Google Adsense sẽ được phép thu thập dữ liệu của toàn bộ trang blog để có hiệu suất hoạt động Adsense tốt nhất.

Robots.txt loại 1

Lưu ý là người dùng có thể thay đổi file robots.txt mặc định của trang Blogspot như sau:

ser-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Disallow: /b

Allow: /

Sitemap: https://m.yingvn.com/sitemap.xml

Robots.txt loại 2

Nếu bạn muốn các công cụ tìm kiếm thu thập dữ liệu 500 bài đăng gần đây nhất trên trang blog của mình, thì bạn nên sử dụng loại robot.txt thứ 2. Nếu bạn đã có hơn 500 bài đăng trên blog của mình, thì bạn có thể thêm một dòng sơ đồ trang web được in đậm màu đỏ.

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Disallow: /b

Allow: /

Sitemap: https://m.yingvn.com/feeds/posts/default?orderby=updated

Lưu ý: Bạn đừng quên thay đổi địa chỉ https://m.yingvn.com/ bằng địa chỉ blog của bạn hoặc tên miền tùy chỉnh.

Robots.txt loại 3

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Disallow: /b

Allow: /

Sitemap: https://m.yingvn.com/atom.xml?redirect=false&start-index=1&max-results=500

Sitemap: https://m.yingvn.com/atom.xml?redirect=false&start-index=501&max

Lưu ý: Bạn đừng quên thay đổi địa chỉ https://m.yingvn.com/ bằng địa chỉ blog của bạn hoặc tên miền tùy chỉnh.

Công thức toán học cho các mục nhập sơ đồ trang web của robot robots.txt như sau:

Sitemap: https://m.yingvn.com/atom.xml?redirect=false&start-index=(m*0)+1&max-results=m

Sitemap: https://m.yingvn.com/atom.xml?redirect=false&start-index=(m*1)+1&max-results=m

Sitemap: https://m.yingvn.com/atom.xml?redirect=false&start-index=(m*2)+1&max-results=m

Sitemap: https://m.yingvn.com/atom.xml?redirect=false&start-index=(m*3)+1&max-results=m

.

.

.

Sitemap: https://m.yingvn.com/atom.xml?redirect=false&start-index=(m*n)+1&max-results=m

Trong đó m = 500 và n = 1, 2, 3, 4,...n. Nếu bạn đã có kinh nghiệm về tối ưu hóa công cụ tìm kiếm (SEO), thì bạn có thể xóa dòng lệnh sau:

Disallow: /search

Nếu bạn không muốn các công cụ tìm kiếm thu thập dữ liệu từ một bài đăng hoặc một trang blogger cụ thể nào đó thì hãy nhớ các dòng lệnh sau:

Đối với một bài đăng cụ thể thì thì thêm dòng sau:

Disallow: /yyyy/mm/post-name.html

Đối với một page cụ thể thì thêm dòng sau:

Disallow: /p/page-name.html

3. Cách sử dụng và quản lý robot.txt tùy chỉnh trên blogspot

Các bước thực hiện như sau:

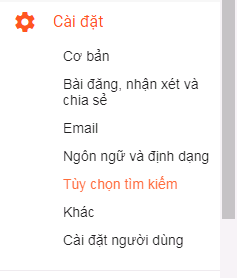

Bước 1: Bạn truy cập vào trang quản lý Blogspot, và nhấn vào Cài đặt > Tùy chọn tìm kiếm > Trình thu thập thông tin và lập chỉ mục.

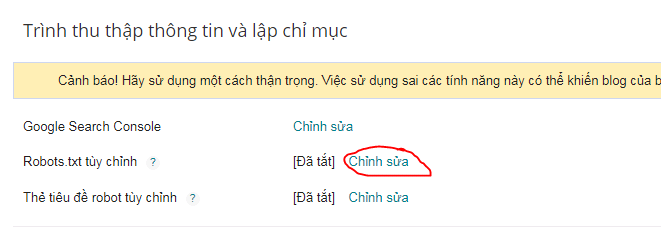

Bước 2: Tại mục này, bạn nhấn vào dòng Robots.txt tùy chỉnh và chọn Chỉnh Sửa.

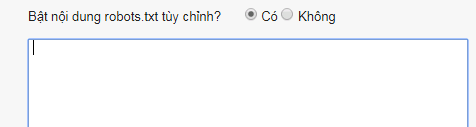

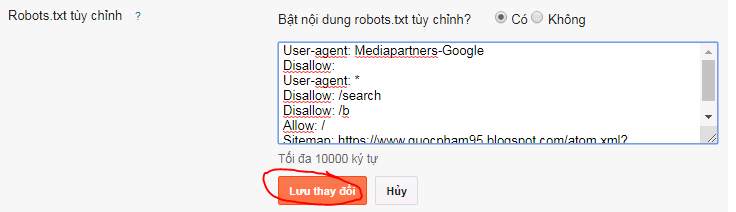

Bước 3: Lúc này bạn nhấn vào ô Có cho câu hỏi Bật nội dung robots.txt tùy chỉnh?.

Bước 4: Bây giờ một ô điền nhập dữ liệu Robots.txt tùy chỉnh sẽ hiện ra bên dưới. Bạn chỉ cần nhập một trong các loại Robots.txt mẫu mà mình đã giới thiệu bên trên cho đúng rồi nhấn Lưu thay đổi.

Vậy là mình đã vừa hướng dẫn các bạn cách sử dụng Robots.txt tùy chỉnh trên Blogspot đơn giản nhất. Mong rằng bài viết này sẽ hữu ích đối với các bạn.

Chúc các bạn thực hiện thành công!

Nguồn : freetuts.net

.png)

Post a Comment